Comment fonctionne un moteur de recherche ?

Les moteurs de recherche sont devenus des outils indispensables dans notre quotidien en ligne. Que vous recherchiez des informations, des produits ou des services, les moteurs de recherche (Comme Google, Bing, Firefox, etc.) jouent un rôle clé pour vous fournir les résultats pertinents. Mais comment fonctionnent-ils réellement ? Dans cet article, nous allons explorer en détail le fonctionnement d’un moteur de recherche, des étapes de base aux algorithmes complexes.

1. Moteur de recherche : Comment ça marche ?

Lorsque vous effectuez une recherche sur internet, le moteur de recherche utilise des robots, également appelés “spiders” ou “crawlers”. Leur rôle est de parcourir tout le contenu disponible sur Internet et de le stocker dans d’immenses bases de données. Ce processus de collecte est essentiel pour permettre au moteur de recherche d’avoir une vue d’ensemble des informations disponibles en ligne.

Ces robots suivent les liens entre les pages web, découvrant ainsi de nouvelles informations à indexer. Ils parcourent le web de manière continue, mais chaque moteur de recherche a sa propre fréquence et sa propre méthode pour mettre à jour ses données. Compte tenu du volume colossal de fichiers présents sur Internet, il est impossible de tout parcourir en une seule journée.

Une fois que les données ont été collectées, le moteur de recherche les analyse et les trie. Il utilise un algorithme complexe pour identifier la nature des documents (musiques, photos, vidéos, textes, logiciels, etc.) et évaluer la qualité des sites internet qui les publient. L’objectif principal d’un moteur de recherche est de fournir rapidement des réponses pertinentes aux recherches des utilisateurs.

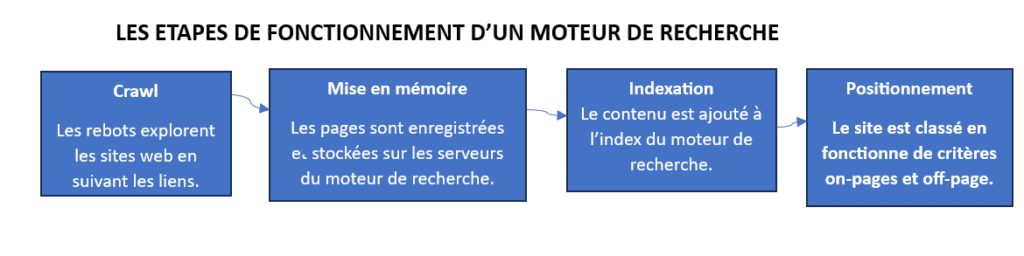

Les étapes de fonctionnement d’un moteur de recherche.

1.1. Exploration / crawl

L’exploration est l’un des éléments fondamentaux du fonctionnement du moteur de recherche. Lorsqu’un moteur de recherche commence à crawler, ses robots parcourent le web en suivant les liens hypertexte présents sur les pages. Ils visitent ainsi différentes pages et découvrent de nouveaux liens à explorer. Ce processus se répète de manière itérative, permettant aux robots de découvrir et d’indexer un nombre considérable de pages.

1.2. La mise en mémoire

La mise en mémoire ou mise en cache est l’étape où les données collectées lors du crawl sont stockées et organisées dans une base de données par les moteurs de recherche sur ses serveurs. Ce sont donc ces données qui sont restituées lorsque vous faites une recherche sur n’importe quel moteur de recherche.

1.2. L’indexation

Une fois que les robots d’exploration ont collecté les données, celles-ci sont indexées afin de les organiser de manière efficace. Autrement dit, c’est lors de cette étape que votre contenu est ajouté sur les moteurs de recherche tels que Google. La position ici va donc dépendre de la qualité de votre contenu d’où il est important de faire un travail de référencement en amont pour avoir un bon classement sur les moteurs de recherche.

1.3. Le positionnement / Classement des résultats

Une fois que le moteur de recherche a identifié les pages pertinentes, il les classe dans un ordre de pertinence. Cela est basé sur différents facteurs, tels que la qualité du contenu, la popularité du site, la pertinence des mots-clés et d’autres signaux de classement. Les moteurs de recherche utilisent des algorithmes complexes pour déterminer l’ordre des résultats et fournir les pages les plus pertinentes en haut de la liste.

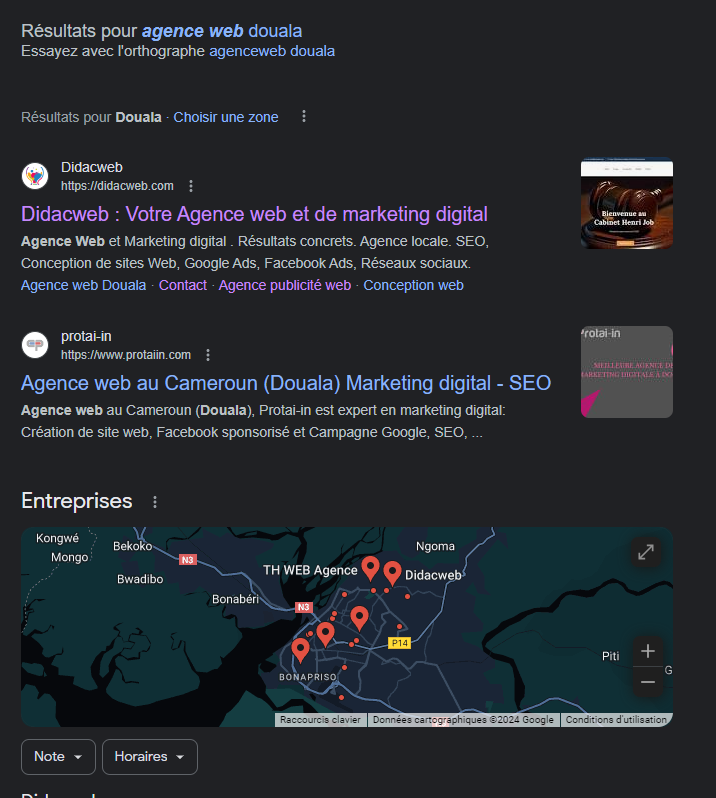

1.4. Affichage des résultats

Enfin, les résultats de la recherche sont affichés à l’utilisateur. Généralement, les moteurs de recherche montrent une liste de liens appelée « pages de résultats de recherche » ou « SERP (Search Engine Results Page) ». Ces pages peuvent également inclure des éléments tels que des extraits de texte, des images, des vidéos ou des résultats spéciaux tels que des connaissances instantanées comme sur l’image suivante :

2. Les différents types de moteurs de recherche ?

Il existe différents types de moteurs de recherche, chacun ayant ses propres caractéristiques et domaines d’application. Voici quelques-uns des types de moteurs de recherche les plus courants :

2.1. Moteurs de recherche généralistes :

Ce sont les moteurs de recherche les plus populaires et les plus largement utilisés, tels que Google, Bing et Yahoo. Ils vous permettent de rechercher une grande variété d’informations sur le web, y compris des pages web, des images, des vidéos, des actualités et bien plus encore.

2.2. Moteurs de recherche spécialisés :

Ces moteurs de recherche se concentrent sur des domaines spécifiques tels que la recherche académique (par exemple, Google Scholar), la recherche médicale (par exemple, PubMed), la recherche d’images (par exemple, Google Images), la recherche de vidéos (par exemple, YouTube) ou la recherche de produits (par exemple, Amazon). Alors pour les cibler, tournez-vous vers des moteurs correspondant à vos besoins pour obtenir de meilleurs résultats.

2.3. Moteurs de recherche de réseaux sociaux :

Il s’agit de moteurs de recherche qui permettent de trouver des informations spécifiques à un réseau social particulier. Par exemple, vous pouvez rechercher des personnes, des pages, des groupes et des publications sur sa plateforme grâce à son moteur de recherche interne de Facebook.

2.4. Moteurs de recherche verticaux :

Ces moteurs de recherche se concentrent sur des secteurs ou des industries spécifiques. Par exemple, il existe des moteurs de recherche spécialisés dans l’immobilier, les voyages, l’emploi, la santé, etc. Ces moteurs de recherche vous offrent des fonctionnalités et des résultats adaptés aux besoins spécifiques de ces secteurs.

2.5. Moteurs de recherche basés sur la confidentialité :

Ces moteurs de recherche mettent l’accent sur la protection de votre vie privée en limitant la collecte et la conservation des données personnelles. Par exemple, DuckDuckGo est un moteur de recherche qui ne suit pas vos activités de recherche et ne les stocke pas non plus.

3. Quels critères définissent la qualité d’un site internet ?

Les moteurs de recherche déploient des agents d’exploration, également connus sous le nom de robots ou de crawler, pour inspecter les sites internet et évaluer leur qualité. Ces agents s’appuient sur des critères spécifiques afin d’attribuer une évaluation de qualité aux différentes pages web.

Dans le domaine du référencement naturel (SEO), on identifie généralement trois piliers fondamentaux : le volet technique du SEO, l’aspect sémantique du SEO et l’obtention de backlinks.

3.1. Le SEO technique

Le SEO technique concerne l’optimisation de l’infrastructure technique de votre site internet, dans le but de faciliter l’exploration et l’indexation par les moteurs de recherche. Cela englobe des éléments tels que l’optimisation de la vitesse de chargement des pages, l’organisation de la structure du site, l’utilisation appropriée des balises HTML, et l’adaptabilité du site aux différents appareils et tailles d’écran.

Quelques-uns des éléments clés du SEO technique sont :

- Vitesse de chargement du site :

La vitesse de chargement d’un site web fait référence au temps qu’il faut pour qu’une page se charge complètement dans un navigateur web. C’est un critère important pour l’expérience utilisateur et pour l’optimisation des moteurs de recherche. La vitesse de chargement de votre site joue un rôle important dans le classement de celui-ci sur les moteurs de recherche tels que Google; plus il se charge rapidement, plus vous avez la chance qu’il soit bien classé sur les résultats des recherches.

- Optimisation mobile

De nos jours, la plupart des personnes naviguent sur internet à travers leurs smartphones et donc avoir un site web responsive est primordial. Même le géant moteur de recherche Google utilise le mobile-first indexing, qui est l’indexation et classement de votre site selon sa version mobile. Donc, pensez toujours à rendre votre site web responsive autant que faire se peut.

- Sitemap XML

Le sitemap XML (Extensible Markup Language) est le plan de votre site qui répertorie toutes les pages du site, leurs relations et leurs différentes caractéristiques. Chaque élément se trouvant sur le sitemap XML est automatiquement indexé par les moteurs de recherche.

- Fichier robots.txt

Le fichier robots.txt est un fichier texte spécial utilisé par les sites web pour communiquer avec les robots des moteurs de recherche. Il agit comme un “panneau de signalisation” pour indiquer aux robots quelles parties de votre site ils peuvent explorer et quelles parties ils doivent éviter.

- Architecture du site et structure des URL

L’architecture du site concerne la façon dont toutes les pages et sections d’un site web sont organisées. C’est comme la structure d’une maison, où chaque pièce a sa place et est reliée aux autres de manière logique. Une bonne architecture de site permet aux visiteurs de trouver facilement ce qu’ils cherchent et facilite également le travail des moteurs de recherche pour explorer et comprendre le contenu de votre site.

- HTTPS

HTTPS (Hypertext Transfer Protocol Secure) est une technologie qui sécurise les échanges de données entre votre site web et ses visiteurs ou utilisateurs. C’est comme un bouclier de protection qui assure la confidentialité et l’intégrité de vos informations lorsqu’elles sont transmises sur Internet. Le HTTPS est un facteur de classement sur les moteurs de recherche alors, tenez en compte avant de mettre votre site en ligne.

- Les données structurées

Les données structurées sont une méthode pour organiser et présenter des informations de manière cohérente et compréhensible par les machines. Imaginez que vous parlez à un ordinateur et que vous lui donnez des instructions très claires sur la signification et le contexte de chaque morceau d’information.

C’est exactement ce que font les données structurées. Elles ajoutent des balises spéciales à chaque type d’information pour dire à l’ordinateur ce que c’est, comme s’il lui donnait des étiquettes.

3.2. Le SEO sémantique

Le SEO sémantique est une approche du référencement qui se concentre sur le sens et la compréhension du contenu d’un site web par les moteurs de recherche. Au lieu de se concentrer uniquement sur des mots-clés spécifiques, le SEO sémantique prend en compte le contexte, les synonymes et les relations entre les mots pour améliorer la pertinence des résultats de recherche.

Pour optimiser le SEO sémantique, il est important de :

- Comprendre l’intention de recherche

L’intention de recherche ici fait référence à l’attente des internautes après une recherche sur le moteur de recherche de leur choix. Alors, l’enjeu lors de la création de contenu pour le web est de connaitre l’intention des utilisateurs afin de proposer des contenus répondant à leurs besoins. Ceci améliore le classement de votre site sur les moteurs de recherche.

- Optimisation des entités

L’optimisation des entités est une approche du référencement qui se concentre sur l’amélioration de la visibilité des informations relatives aux entités, telles que les personnes, les lieux, les organisations, les produits, etc. dans les résultats de recherche. Cela implique de structurer et de marquer ces entités avec des balises spéciales, appelées balises de données structurées, afin de fournir aux moteurs de recherche des informations précises et détaillées sur ces entités.

L’optimisation des entités dans vos contenus web permet non seulement d’améliorer la compréhension du contenu par les moteurs de recherche, mais aussi d’afficher des informations enrichies, telles que des images, des avis, des horaires d’ouverture, des prix, etc., directement dans les résultats de recherche.

- Recherche de mots-clés basée sur des sujets :

La recherche de mots-clés basée sur des sujets est une approche du référencement qui consiste à se concentrer sur des sujets ou des thèmes plus larges plutôt que sur des mots-clés spécifiques. Au lieu de se limiter à des mots-clés individuels, cette approche vise à comprendre les intentions de vos utilisateurs et à créer du contenu pertinent autour de ces sujets.

L’idée derrière la recherche de mots-clés basée sur des sujets est de fournir de complètes réponses approfondies aux questions des utilisateurs. Cela implique de créer du contenu informatif et de qualité qui aborde différents aspects d’un sujet donné.

3.3. L’acquisition de backlinks

Le critère principal pris en compte par les moteurs de recherche pour évaluer la qualité de votre site internet est sa popularité, est basée sur le nombre de visiteurs et de liens externes pointant vers lui. Cependant, cette approche a été faussée par la pratique du “link building” artificiel, où des sites paient pour obtenir des liens, ce qui a conduit à une dégradation de la qualité des résultats de recherche.

Les moteurs de recherche, conscients de cette manipulation, ont renforcé leurs contrôles et pénalisent désormais les sites qui utilisent ces pratiques. Ainsi, il est devenu essentiel pour les sites de se concentrer sur d’autres critères de qualité, tels que l’organisation du contenu, le temps de chargement, les liens internes et la compatibilité avec différents appareils.

Conclusion

La bataille entre les gestionnaires de sites respectueux des règles et les experts SEO qui cherchent à exploiter les failles pour améliorer leur positionnement est constante. Les moteurs de recherche jouent le rôle d’éducateurs et de justiciers en sanctionnant les pratiques non conformes et en favorisant la qualité du contenu et l’expérience utilisateur. Les nouveaux arrivants doivent être prudents lorsqu’ils cherchent des conseils en SEO, car l’engagement de professionnels utilisant des techniques risquées peut avoir des conséquences négatives. En adoptant des stratégies SEO légitimes axées sur le contenu de qualité, l’optimisation technique et l’acquisition de backlinks naturels, les gestionnaires de sites peuvent établir une présence en ligne solide et durable.

Découvrez aussi d’autres articles dans la même catégorie :

- Quel est le rôle d’une agence SEO ?

- Les 9 avantages clés du SEO pour propulser votre site sur Google en 2024

- Taux de rebond : C’est quoi et comment le réduire ?

- Comment fonctionne un moteur de recherche ?

- SEO vs SEA : différences, avantages et complémentarités

- Les meilleures astuces pour optimiser votre autorité de domaine (DA)

- WordPress : Guide du Débutant

- Optimisation SEO : optimiser son contenu web en 9 étapes

- Les meilleures stratégies pour apparaître en première page sur Google

- Qu’est-ce que le taux de conversion et comment l’optimiser ?

- Comment améliorer la vitesse de chargement d’un site web ?

- Booster les visites de votre site internet avec le netlinking

- Pourquoi faire un audit SEO ?

- Apprendre et comprendre Google index